서론

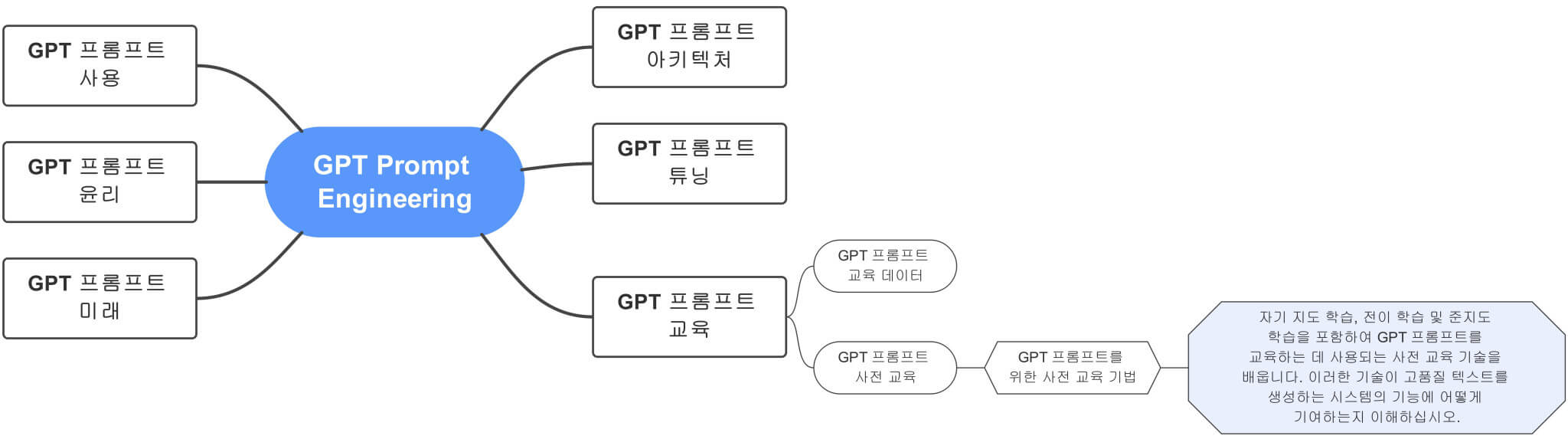

GPT와 같은 대규모 언어 모델의 등장은 인공 지능 및 자연어 처리 분야에 혁명을 일으켰습니다. 이 모델은 인간과 유사한 텍스트 생성부터 질문에 답하고 코드 작성까지 놀라운 기능을 보여주었습니다. GPT 모델은 언어 콘텍스트를 이해하고 콘텍스트 관련 응답을 생성하는 데 도움이 되는 사전 교육 및 미세 조정 기술의 조합 덕분에 인상적인 성능을 발휘합니다. 이번 글에서는 특히 AI를 더 배우고자 하는 사람들의 학습을 위해 GPT 모델에 사용되는 사전 교육 기법을 살펴봅니다. 이러한 기법에 대한 상세 하면서도 이해하기 쉬운 개요와 최첨단 언어 모델을 만드는 데 있어 그 중요성에 대해 설명하는 것이 목표입니다.

목차

GPT 프롬프트를 위한 사전 교육 기법

1. 사전 교육 기법: 기본 사항

사전 교육은 GPT 모델 개발의 첫 번째 단계로, 대량의 텍스트 데이터에 대해 모델을 교육합니다. 이 단계는 모델이 언어의 구조, 의미론 및 구문을 학습하는 데 도움이 됩니다. 사전 훈련에 사용되는 두 가지 기본 기술은 비지도 학습과 마스킹된 언어 모델링입니다.

- 비지도 학습:

비지도 학습은 레이블이 지정된 데이터를 사용하지 않고 모델을 교육하는 프로세스를 말합니다. 대신 모델은 자체적으로 입력 데이터의 패턴과 구조를 학습합니다. 이것은 책, 기사 및 웹 페이지와 같은 크고 다양한 텍스트 데이터 세트에서 모델을 훈련함으로써 달성됩니다. - 마스킹된 언어 모델링:

마스킹된 언어 모델링은 문장에서 특정 비율의 단어를 마스킹하는 기술이며 모델은 나머지 단어가 제공하는 콘텍스트를 기반으로 마스킹된 단어를 예측하는 작업을 수행합니다. 이 기술은 모델이 단어 간의 관계를 이해하고 상황에 맞는 텍스트를 생성하는 방법을 배우는 데 도움이 됩니다.

2. 사전 훈련 기법: GPT 모델

GPT 모델의 사전 학습 단계에는 Transformer 아키텍처와 self-attention 메커니즘이라는 두 가지 주요 기술이 포함됩니다.

- Transformer 아키텍처:

2017년에 Vaswani 등이 소개한 Transformer 아키텍처는 GPT 모델의 기초가 되었습니다. 기존의 순환 및 컨볼루션 계층을 self-attention 계층으로 대체하는 일종의 신경망 아키텍처입니다. 이를 통해 모델은 텍스트의 장거리 종속성을 보다 효과적으로 처리할 수 있습니다. - self-attention 메커니즘:

Self-Attention 메커니즘은 Transformer 아키텍처의 핵심 구성 요소로, 모델이 문장에서 서로 다른 단어의 관계를 기반으로 중요도를 평가할 수 있게 해 줍니다. 이 메커니즘은 GPT 모델이 입력 데이터에서 단어 간의 종속성을 효과적으로 캡처하여 상황에 맞게 적절하고 일관된 텍스트를 생성하는 데 도움이 됩니다.

3. 사전 훈련 기법의 중요성

GPT 모델에 사용되는 사전 교육 기술을 이해하는 것은 다음과 같은 이유로 AI를 사용하는 사람이나 개발자에게 매우 중요합니다.

- 이러한 모델이 복잡한 작업을 수행할 수 있도록 하는 기본 메커니즘에 대한 통찰력을 제공하여 자연어 처리 및 인공 지능에 대한 더 깊은 이해를 촉진합니다.

- 이것은 개발자들이 비지도 학습의 중요성과 최신 언어 모델을 개발하는 데 있어 대규모의 다양한 텍스트 데이터 세트 사용의 중요성을 인식하도록 돕습니다.

- GPT 모델의 기능을 더욱 향상할 수 있는 새로운 사전 교육 기술을 탐구하고 개발하도록 개발자들에게 영감을 줄 수 있습니다.

결론

결론적으로 비지도 학습, 마스킹된 언어 모델링, 트랜스포머 아키텍처 및 셀프 어텐션 메커니즘과 같은 GPT 모델에 사용되는 사전 학습 기술은 놀라운 성능에 중요한 역할을 합니다. 이러한 기술을 이해함으로써 사용자나 개발자들은 최첨단 언어 모델의 작동에 대한 귀중한 통찰력을 얻고 이 지식을 자신의 연구 및 프로젝트에 적용할 수 있습니다. AI 분야가 계속 발전함에 따라 이러한 기술을 탐색하고 개선하는 것은 미래에 훨씬 더 강력한 언어 모델을 개발하는 데 필수적인 요소로 남을 것입니다.

'프롬프트 만들기 > GPT 프롬프트 엔지니어링' 카테고리의 다른 글

| GPT 프롬프트의 상위 애플리케이션 (0) | 2023.03.30 |

|---|---|

| GPT Prompt Engineering: AI의 힘 활용하기 (0) | 2023.03.30 |

| GPT 프롬프트 교육을 위한 필수 데이터 (0) | 2023.03.29 |

| GPT 프롬프트 성능 최적화 (0) | 2023.03.29 |

| GPT 프롬프트를 필요에 따라 미세 조정하는 방법 (0) | 2023.03.29 |

댓글